Última actualizacón: 20 marzo 2018 a las 21:53

En la primera parte de esta anotación hemos analizado qué son las experiencias cercanas a la muerte. Ahora vamos a glosar los principales artículos científicos que han estudiado estas experiencias para, acto seguido, ofrecer una explicación de qué es la consciencia y las implicaciones que las investigaciones en el campo de las ECM pueden tener en la neurociencia.

Bruce Greyson (que creó la escala que lleva su nombre para determinar la existencia de una ECM) ya planteó en los años ochenta del siglo pasado la necesidad de llevar a cabo estudios prospectivos en pacientes con riesgo de sufrir una muerte repentina por paro cardíaco como el medio más idóneo para eliminar el sesgo en la elección de los casos. A continuación vamos a analizar los primeros estudios de este tipo.

El Dr. Sam Parnia (actualmente profesor asistente de medicina de cuidados críticos en la Universidad Estatal de Nueva York) junto con sus colaboradores llevaron a cabo un estudio piloto en 2001 diseñado para evaluar la frecuencia en que se daban ECM en personas que habían sobrevivido a paros cardíacos, así como para determinar las características de estas experiencias. Los resultados se publicaron en la revista Resuscitation.

Se incluyeron en el estudio todas aquellas personas que habían sobrevivido a un paro cardíaco y que habían permanecido ingresadas en un hospital del Reino Unido (el Southampton General Hospital). El estudio se realizó durante un periodo de un año y se interrogó a los pacientes (mientras permanecían aún hospitalizados) acerca de si guardaban algún recuerdo del tiempo en que habían permanecido inconscientes (no se realizó ninguna pregunta directa sobre si habían experimentado una ECM, si habían tenido la sensación de estar fuera del cuerpo u otras experiencias similares). Se aplicó la escala de Greyson como criterio de demarcación y se incluyeron datos fisiológicos como los niveles de gasometría arterial y periférica (junto con niveles de sodio y potasio), datos de la medicación administrada así como cualquier registro de anormalidades en el ritmo cardíaco durante la parada.

Para comprobar la realidad de las afirmaciones de algunos pacientes que afirmaban haber experimentado la sensación de estar fuera del cuerpo, flotando sobre el equipo médico durante las maniobras de reanimación, los investigadores cubrieron con tablones los techos de las habitaciones, colocando en la cara superior unas figuras de forma que sólo desde una posición ventajosa sobre el techo podían verse. Desgraciadamente, y también de forma atípica, ninguno de los pacientes que afirmaron vivir una ECM en esta muestra experimentó esta sensación.

Un total de 63 pacientes cumplieron todos los requisitos del estudio: siete de ellos indicaron que guardaban recuerdos de su periodo de inconsciencia (11,1%), cuatro de los cuales (6,3% del total de la muestra) habían experimentado una ECM según los criterios de la escala de Greyson (siete puntos o más).

Tabla del estudio de Greyson.

Debido al pequeño número de pacientes que tuvieron una ECM no fue posible extraer conclusiones claras acerca de las posibles causas fisiológicas, aunque se constató que la presión parcial de oxígeno era más alta en el grupo que experimentó una ECM que en el grupo control (a pesar de que en el artículo se sugiere que este dato podía descartar la influencia de la anoxia en el origen del fenómeno, los investigadores fueron precavidos y no destacaron esta conclusión dado el poco valor estadístico de los datos).

Los investigadores concluyeron que las ECM tienen lugar mientras los pacientes permanecen inconscientes, lo que contraviene los postulados médicos que niegan la posibilidad de que haya ningún tipo de experiencia subjetiva o capacidad de memorizar dada la nula actividad del cerebro en este estado. Como se ha apuntado que estas experiencias pueden tener lugar justo antes de perder la consciencia (a pesar de que el paso al estado comatoso tras un paro cardíaco sucede en pocos segundos) o en la fase de recuperación, reconocen que se precisan más datos para confirmar el desarrollo temporal de las ECM y descartar o probar esta hipótesis.

Ese mismo año se publicaron los resultados de otro estudio a gran escala realizado en diez hospitales holandeses. Dirigido por el cardiólogo Pim Van Lommel, incluyó un total de 344 personas que habían sufrido un paro cardíaco y fueron resucitadas con éxito. Todo ellos fueron entrevistados pocos días después, y del total de pacientes estudiados, 62 de ellos (un 18%) reconocieron haber experimentado una ECM, de los cuales 41 (12%) informaron de una experiencia profunda. Todos los pacientes estuvieron clínicamente muertos (según los registros electrocardiográficos).

En el estudio se definen las ECM como los recuerdos de todas las impresiones referidas durante un estado especial de consciencia, que incluyen elementos específicos tales como la sensación de estar fuera del cuerpo, sentimientos agradables, la visión de un túnel, una luz, estar junto a parientes fallecidos, o una revisión de la vida. Por otro lado, la muerte clínica se define como un periodo de inconsciencia provocado por un suministro deficiente de sangre al cerebro provocado bien por una circulación sanguínea insuficiente, respiración insuficiente o ambas causas. Si en esta situación la reanimación cardiopulmonar no comienza en 5 o 10 minutos, se produce un daño irreparable al cerebro y el paciente muere.

Para determinar si ha habido o no una ECM los investigadores utilizaron la escala WCEI (con una puntuación de 6 o más para considerar que la experiencia ha sido profunda). Compararon el grupo de 62 pacientes que experimentaron una ECM con los supervivientes que no habían referido ningún recuerdo (el grupo control) en relación a una serie de índices demográficos, médicos, farmacológicos y psicológicos. El objetivo era calcular la frecuencia en la que se producían las ECM en pacientes que habían sufrido un paro cardíaco (una situación médica crítica objetiva) y determinar los factores que afectaban a la frecuencia, el contenido y la profundidad de la misma.

Comprobaron que factores como la duración del paro cardíaco o la duración del periodo de inconsciencia, la medicación, el miedo a la muerte antes del infarto o el tiempo que transcurrió entre la ECM y la entrevista para recabar los datos no guardaban relación con el hecho de sufrir una ECM. Sin embargo, si constataron que las personas menores de 60 años eran más susceptibles a sufrir una ECM que las mayores. Otro dato relevante fue que la mayoría de los pacientes que experimentaron una ECM, especialmente una de tipo profundo, murieron finalmente en los 30 días posteriores a la reanimación.

Este estudio incluyó un aspecto longitudinal al seguir los dos grupos después de dos años y luego a los ocho años, para evaluar el efecto del tiempo, la memoria y los mecanismos de supresión en el proceso de transformación vital tras una ECM (los datos se recabaron entre 1988 y 1992). Los resultados confirmaron los estudios previos al indicar que las ECM producían efectos a largo plazo en las personas en términos de, por ejemplo, perder el miedo a morir, una intuición aumentada etc.

En cuanto a las causas, los investigadores concluyeron que los factores médicos no podían explicar las ECM y, aunque todos los pacientes analizados estuvieron clínicamente muertos, la mayoría no experimentó una ECM. Sostienen que si se tomaran en cuenta como desencadenantes de una ECM los factores puramente fisiológicos que resultan de la anoxia cerebral, la mayoría de los pacientes analizados deberían haber tenido esta experiencia. Concluyen que ni la medicación de los pacientes ni tampoco los factores psicológicos son determinantes para sufrir una ECM.

Quizás lo más llamativo sea que un estudio sobre este tema tan polémico fuese publicado en una de las revistas líderes en la investigación médica (The Lancet). Van Lommel explicó en una entrevista que nunca antes se había realizado un estudio tan sistemático sobre las experiencias de personas que fueron declaradas muertas y después volvieron a la vida. Afirma:

En ese momento estas personas no sólo están conscientes; su consciencia está incluso más expandida que nunca. Pueden pensar con extrema claridad, tienen recuerdos que se remontan a su niñez más temprana y experimentan una conexión intensa con todo y con todos a su alrededor. ¡Y sin embargo el cerebro no muestra ninguna actividad en absoluto!

Como ya hemos indicado, algunos científicos sostienen que estas experiencias pueden ocurrir en el momento en el que aún queda alguna función cerebral, aunque sea mínima. Van Lommel responde:

Cuando el corazón deja de latir, el riego sanguíneo se detiene en el plazo de un segundo. Entonces, 6,5 segundos más tarde, la actividad del EEG [electroencefalograma] comienza a cambiar debido a la escasez de oxígeno. Después de 15 segundos hay una línea recta y plana, y la actividad eléctrica en la corteza cerebral desaparece completamente. No podemos medir la actividad en el tallo cerebral, pero experimentos en animales han demostrado que esa actividad también se ha detenido allí.

Más aún, se puede demostrar que el tallo cerebral ya no está funcionando porque regula nuestros reflejos básicos, tales como la respuesta de la pupila y el reflejo de tragar, que ya no responden. De ese modo puedes introducir fácilmente un tubo por la garganta de una persona. El centro respiratorio también se detiene. Si el individuo no es reanimado en un plazo de 5 a 10 minutos, sus células cerebrales se dañan de forma irreversible.

Por último, en el análisis que estamos haciendo de los principales estudios prospectivos sobre las ECM, vamos a hablar del estudio que el Dr. Greyson llevó a cabo con todos los pacientes admitidos en la unidad de cuidados intensivos cardíacos del Hospital de la Universidad de Virginia durante un periodo de 30 meses (se excluyeron aquellos que estaban demasiado enfermos, psicóticos o disminuidos cognitivamente como para ser entrevistados). Los resultados se publicaron en la revista General Hospital Psychiatry en 2003 tomando como base de partida la hipótesis de que la incidencia de las ECM sería mayor entre los pacientes que habían sufrido un paro cardíaco de aquellos con otros problemas cardíacos (para diferenciar los problemas que pueden afectar al corazón recomiendo este enlace).

De la muestra total de 1595 pacientes admitidos en la unidad de cuidados intensivos cardíacos, a 116 (7%) se les diagnosticó un paro cardíaco. La ECM se determinó siguiendo la escala de Greyson y las entrevistas a los pacientes se llevaron a cabo dentro de los seis días posteriores a la admisión. Del número total de pacientes estudiados, 27 mostraron una puntuación de siete o más en la escala de Greyson, por lo que fueron catalogados dentro del grupo ECM; el resto, 1568 pacientes, fueron incluidos en el grupo de control. Comparados con los pacientes que no vivieron una ECM, el grupo ECM no difería en términos sociodemográficos, de apoyo social, calidad de vida, aceptación de su enfermedad, función cognitiva, capacidad para actividades físicas, grado de disfunción cardíaca, proximidad objetiva a la muerte o prognosis coronaria.

Entre las conclusiones del estudio destacaremos que se confirmó la diferente incidencia en ECM que existe entre los pacientes que entraron en el hospital por un paro cardíaco frente al resto de enfermos coronarios (según los datos facilitados, un paciente con paro cardíaco tiene una posibilidad 10 veces mayor de experimentar una ECM que el resto). Según Greyson, este dato apoya el vínculo que hay entre vivir este tipo de experiencias y la proximidad de la muerte. La pregunta obvia ante esta afirmación sería cuestionarse porqué la frecuencia de pacientes que afirman haber experimentado una ECM tras un paro cardíaco es tan baja (un 10%) del global de pacientes que sobrevivieron tras ese paro.

La respuesta es que este porcentaje no representa la proporción de personas que han sobrevivido a un paro cardíaco y que han experimentado una ECM, sino aquellos que han sido capaces de recordar esta experiencia y además han querido contarla a los investigadores. Tres factores pueden incidir en esta circunstancia. En primer lugar, es habitual padecer amnesia tras un paro cardíaco; en segundo término, este factor está relacionado con la edad: al igual que en el estudio holandés, en éste se constata que las personas menores de 60 años tienen mejores recuerdos de una ECM quizás debido a que los pacientes de mayor edad tienen más probabilidad de sufrir isquemia cerebral (es decir, cuando la sangre no puede llegar a ciertas partes del cerebro y se interrumpe el suministro de oxígeno a esas zonas); por último, otro factor que puede reducir el porcentaje de personas que cuentan su experiencia es el miedo a que sean ridiculizados o considerados enfermos mentales.

El Dr. Greyson concluye finalmente que ningún modelo fisiológico ni psicológico puede explicar por sí mismo todas las características de las ECM. Sin embargo, reconoce que algunas de estas características sí que pueden atribuirse a mecanismos neuroquímicos pero que, en cualquier caso, como las anteriores investigaciones han apuntado, los complejos procesos sensoriales y de percepción que se manifiestan durante un periodo de aparente muerte clínica suponen un reto para la idea de que la consciencia está localizada exclusivamente en el cerebro.

Lo que quedó patente con estos resultados es que era necesario llevar a cabo más investigaciones a gran escala, empleando métodos cada vez más precisos para intentar desentrañar el origen o causas que provocaban las ECM. Así, en 2008 el Dr. Sam Parnia presentó formalmente el denominado The Human Consciousness Project (Proyecto Conciencia Humana), donde convergían un grupo internacional de científicos para investigar en condiciones de laboratorio los procesos neuronales implicados en las diferentes facetas de la conciencia humana, su naturaleza y su relación con el cerebro.

El primer estudio lanzado por el proyecto se denominó AWARE (del inglés AWAreness during REsuscitation o conciencia durante la reanimación) con el objeto de analizar la relación de la mente con el cerebro durante el estado de muerte clínica. A pesar de que se había anunciado la publicación de los resultados durante el pasado año 2013, a fecha de hoy, la página web del proyecto sigue sin concretar cuándo se harán públicos y cuáles serán las conclusiones. Actualizaremos esta anotación si algún día se concluye.

Consciencia

Hasta ahora hemos analizado con cierta profundidad todos los aspectos relacionados con las experiencias cercanas a la muerte, pero para tener una visión completa de esta materia necesitamos comprender qué entendemos por consciencia y cuál es el estado actual de la investigación neurológica en este campo.

El diccionario de la Real Academia de la Lengua ofrece cuatro acepciones del término conciencia:

(Del lat. conscientĭa, y este calco del gr. συνείδησις).

1. f. Propiedad del espíritu humano de reconocerse en sus atributos esenciales y en todas las modificaciones que en sí mismo experimenta.

2. f. Conocimiento interior del bien y del mal.

3. f. Conocimiento reflexivo de las cosas.

4. f. Actividad mental a la que solo puede tener acceso el propio sujeto.

5. f. Psicol. Acto psíquico por el que un sujeto se percibe a sí mismo en el mundo.

Poro otro lado, encontramos tres acepciones del término consciencia:

(Del lat. conscientĭa).

1. f. conciencia.

2. f. Conocimiento inmediato que el sujeto tiene de sí mismo, de sus actos y reflexiones.

3. f. Capacidad de los seres humanos de verse y reconocerse a sí mismos y de juzgar sobre esa visión y reconocimiento.

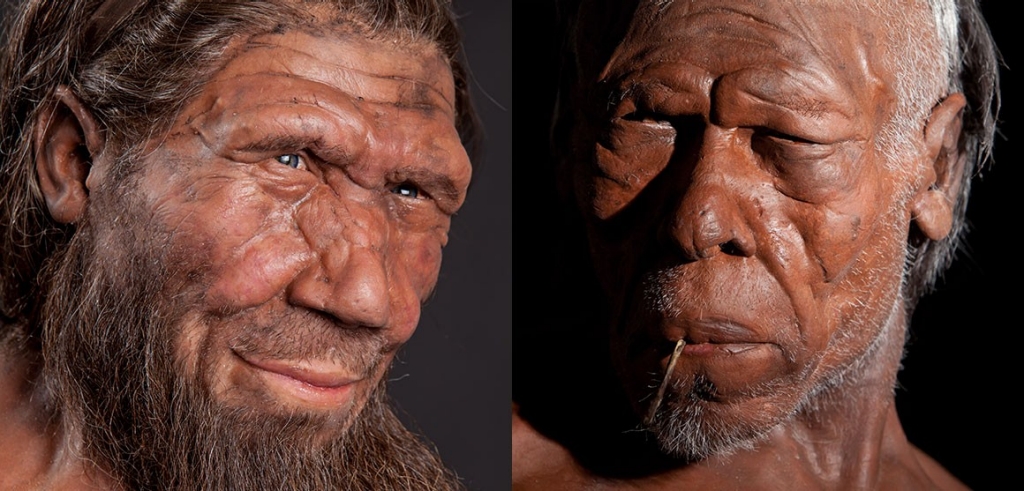

Bien, una vez sentado lo anterior, la pregunta esencial que deberíamos responder es ¿cómo surge la conciencia? En la investigación y análisis de esta materia hay dos grandes corrientes de pensamiento: una es la perspectiva que podríamos llamar localizacionista, que señala que la conciencia ocurre en ciertas regiones concretas del cerebro; la otra argumenta que la conciencia es un proceso holístico, global, que resulta de la actividad de redes de neuronas que se comunican entre sí y originan propiedades emergentes (las propiedades emergentes son aquellas que no se pueden explicar analizando los componentes de un sistema, es decir, son propiedades que estos componentes no tendrían de forma aislada sino que surgen únicamente como producto de la interacción entre ellos).

Siguiendo estas dos corrientes, vamos a exponer los puntos de vista de dos neurocientíficos cada uno de los cuales sostiene una visión diferente pero que comparten la convicción de que el enigma de la conciencia no es un problema único; antes bien, engloba múltiples fenómenos pendientes de explicación: la autoconciencia (la facultad de poder examinar nuestros propios deseos y pensamientos), el contenido de la conciencia (aquello de lo que se es consciente en un momento cualquiera) y la forma en que los procesos cerebrales se relacionan con la conciencia y la no-conciencia, entre otros.

Según plantea Christof Koch, profesor en el Instituto Tecnológico de California y jefe científico del Instituto Allen para la Ciencia del Encéfalo en Seattle, para generar la experiencia consciente un único grupo de neuronas se activa en regiones concretas del encéfalo de manera específica. Por tanto, cada “percepto consciente” (término que se refiere a la representación e interpretación que el cerebro hace de los estímulos procedentes de los sentidos) está asociado con una coalición específica de neuronas.

Junto con este concepto debemos tratar el de “correlato neuronal de conciencia” (CNC). Los neurocientíficos prefieren este complejo término al más simple de conciencia quizás por la dificultad de hallar una definición clara que sea aceptada por todos. Podemos definirlo como el conjunto mínimo de eventos (externos) y mecanismos (internos) que son suficientes para generar una percepción consciente específica. La perturbación o interrupción de cualquier correlato neuronal de conciencia altera su percepto asociado o provoca la desaparición del mismo.

En el plano fisiológico, el sustrato probable de un CNC es una coalición de neuronas piramidales (un tipo de neurona que establece comunicaciones a larga distancia) alojadas en la corteza cerebral. Según esta aproximación, las neuronas forman parte de bastas redes y sólo en tal contexto generan experiencia consciente. La mente o conciencia se hallaría de esta forma claramente situada en la corteza cerebral.

Por su parte, Susan Greenfield opina que para cada experiencia consciente las neuronas distribuidas por el cerebro se sincronizan en “asambleas” coordinadas y luego se dispersan; la conciencia, por tanto, se genera por un incremento cuantitativo en la actividad neuronal del cerebro. Parte de la hipótesis de que no existe ninguna cualidad “mágica” e intrínseca en ninguna región cerebral o conjunto de neuronas que sea responsable de la conciencia, la clave está en el proceso en sí. Según este modelo, la conciencia varía de forma gradual desde un momento al siguiente. La gran cuestión que queda por resolver es la forma en que los fenómenos fisiológicos que tienen lugar en el cerebro se traducen en lo que nosotros experimentamos como conciencia.

Volviendo a Van Lommel, opina que las ECM sólo pueden explicarse si asumimos que la consciencia, junto con todas nuestras experiencias y memorias, se localiza fuera del cerebro. La siguiente pregunta es obvia, ¿dónde? Esta es su respuesta:

Sospecho que hay una dimensión en la que se almacena esta información, una clase de consciencia colectiva a la que sintonizamos para acceder a nuestra identidad y nuestras memorias

Ahí es nada. En un artículo que escribió en 2006 (Near-Death Experience, Consciousness and the Brain) ahondó más en esta propuesta acudiendo a la mecánica cuántica como forma de explicar esa otra “dimensión” donde se hallaría la consciencia. No nos vamos a detener en esta explicación porque, bajo nuestro punto de vista, no es más que una exposición en voz alta de una idea incoherente. El físico Victor Stegner ha reiterado en numerosas ocasiones su preocupación del surgimiento de un «nuevo mito» en el pensamiento moderno que sostiene que la física cuántica ha invalidado la visión materialista y reduccionista del universo, cuando lo que sucede llanamente es que se malinterpretan o no se entienden sus postulados. En cualquier caso, en las referencias incluyo el artículo por si alguien tiene más interés y desea profundizar. Van Lommel finalmente decidió abandonar su carrera de cardiología para dedicarse a tiempo completo a investigar estas experiencias. Fundó la Fundación Merkawah en La Haya, como una rama autónoma de la “Asociación Internacional para Estudios Cercanos a la Muerte” (IANDS – International Association for Near-Death Studies).

No quería terminar esta anotación sin exponer los puntos de vista del Dr. Francisco Mora Teruel. A él le gusta explicar qué es el cerebro y la mente acudiendo a un símil según el cual el cerebro es un instrumento musical (pensemos en un piano). Este instrumento puede ser analizado desmontándolo para separar sus componentes y así poder comprender su funcionamiento. Para muchos, el cerebro es un órgano capaz de ser analizado en todos y cada uno de sus elementos moleculares, celulares y anatómicos. Por su parte, la mente también sería fácil entenderla como una melodía, una composición musical. Algo que aún siendo temporal, no tiene espacio, no es material.

La cuestión es que la resolución del problema mente-cerebro sería como analizar las partes de un piano tratando de encontrar en ellas la melodía que acaba de sonar. Para resolver este inconveniente habría que invocar la existencia de algo o alguien que tocara el piano, es decir, un elemento extracerebral, de otra naturaleza (lo que algunos llaman espíritu).

Sin embargo, para el profesor Mora no hay misterio. Sostiene que ni en la filosofía ni en la neurociencia se mantienen hoy posiciones dualistas. Hay un posicionamiento general, casi unánime, acerca de la idea de que es el propio cerebro el generador y último responsable de los procesos mentales. Las disensiones entre filósofos, entre los propios neurocientíficos y entre filósofos y neurocientíficos están únicamente en lograr comprender cómo se establece la relación, causal o no, entre los mecanismos cerebrales y los procesos mentales.

Su posicionamiento a este respecto está con la llamada teoría de la identidad. Lo que defiende esta teoría es que entre el cerebro y la mente no hay causación, la actividad cerebral son los procesos mentales. Es decir, la actividad neurobiológica del cerebro cuando se expresa en la conducta y el pensamiento es lo que llamamos procesos mentales o mente, y es entonces cuando surgen con una naturaleza aparentemente inmaterial, espiritual si se quiere. A la luz de esta forma de pensar, los procesos cerebrales y los procesos mentales son una misma cosa sólo que estudiados, analizados y expresados utilizando técnicas, instrumentos de análisis y lenguajes diferentes.

Por supuesto que el materialismo no es un hecho establecido en el sentido que, por ejemplo, lo es la estructura helicoidal del ADN. En este sentido, todavía es posible (aun cuando las evidencias actuales no lo apoyen) que el dualismo pueda ser verdad. Aun así, y a pesar de la remota posibilidad de que nuevos descubrimientos reivindiquen a Descartes, el materialismo, como lo es la revolución darwiniana, es la hipótesis de trabajo más segura.

Referencias:

Parnia, S., et al. (2001), «A qualitative and quantitative study of the incidence, features and aetiology of near death experiences in cardiac arrest survivors«. Resuscitation, vol. 48, múm. 2, p. 149-156.

Lommel, Pim Van, et al. (2001) «Near-death experience in survivors of cardiac arrest: a prospective study in the Netherlands«, The Lancet, núm. 358, p. 2039-2045.

Greyson, B. (2003), «Incidence and correlates of near-death experiences in a cardiac care unit«. General Hospital Psychiatry, vol. 25, núm. 4, p. 269-276.

Van Lommel, P. (2006), «Near-death experience, consciousness, and the brain: A new concept about the continuity of our consciousness based on recent scientific research on near-death experience in survivors of cardiac arrest«. World Futures, vol. 62, núm. 1-2, p. 134-151.

Mora, F. y Barraquer Bordás, L. (1995), El problema cerebro-mente. Madrid: Alianza, 288 p.

Koch, C. y Greenfield, S. (2007), «¿Cómo surge la consciencia?». Investigación y Ciencia, núm. 375, p. 50-57.

Pueden descargar la anotación completa en en los siguientes formatos: